Google hat heute sein schnelles und günstiges Gemini 3 Flash-Modell veröffentlicht, das auf dem im letzten Monat vorgestellten Gemini 3 basiert und OpenAI die Show stehlen möchte. Das Unternehmen macht dieses Modell außerdem zum Standardmodell in der Gemini-App und im KI-Modus der Suche.

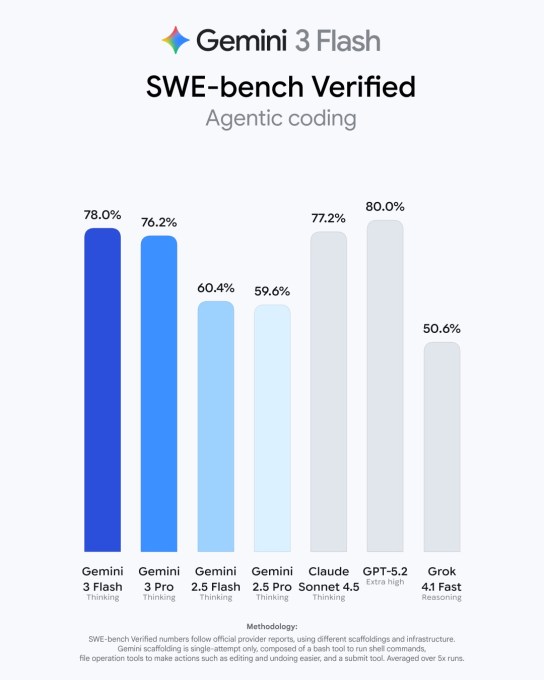

Das neue Flash-Modell erscheint sechs Monate nach der Ankündigung des Gemini 2.5 Flash-Modells von Google und bietet erhebliche Verbesserungen. Im Benchmark übertrifft das Gemini 3 Flash-Modell seinen Vorgänger deutlich und erreicht in einigen Bereichen die Leistung anderer Spitzenmodelle wie Gemini 3 Pro und GPT 5.2.

So erzielte es beispielsweise ohne Tool-Nutzung 33,7 % im Benchmark „Humanity’s Last Exam“, der Fachwissen in verschiedenen Bereichen testet. Zum Vergleich: Gemini 3 Pro erzielte 37,5 %, Gemini 2.5 Flash 11 % und das neu veröffentlichte GPT-5.2 34,5 %.

Im Multimodalitäts- und Reasoning-Benchmark MMMU-Pro übertraf das neue Modell alle Konkurrenten mit einer Punktzahl von 81,2 %.

Einführung für Verbraucher

Google macht Gemini 3 Flash weltweit zum Standardmodell in der Gemini-App und ersetzt damit Gemini 2.5 Flash. Nutzer können für Mathematik- und Programmierfragen weiterhin das Pro-Modell im Modell-Auswahlmenü wählen.

Das Unternehmen sagt, dass das neue Modell besonders gut darin ist, multimodale Inhalte zu erkennen und darauf basierende Antworten zu geben. Beispielsweise kann man ein kurzes Pickleball-Video hochladen und um Tipps bitten; man kann eine Skizze zeichnen und das Modell raten lassen, was gezeichnet wird; oder man kann eine Audioaufnahme hochladen, um eine Analyse zu erhalten oder ein Quiz zu generieren.

Das Unternehmen erklärte außerdem, dass das Modell die Absicht der Nutzeranfragen besser versteht und visuellere Antworten mit Elementen wie Bildern und Tabellen generieren kann.

Join the Disrupt 2026 Waitlist

Add yourself to the Disrupt 2026 waitlist to be first in line when Early Bird tickets drop. Past Disrupts have brought Google Cloud, Netflix, Microsoft, Box, Phia, a16z, ElevenLabs, Wayve, Hugging Face, Elad Gil, and Vinod Khosla to the stages — part of 250+ industry leaders driving 200+ sessions built to fuel your growth and sharpen your edge. Plus, meet the hundreds of startups innovating across every sector.

Join the Disrupt 2026 Waitlist

Add yourself to the Disrupt 2026 waitlist to be first in line when Early Bird tickets drop. Past Disrupts have brought Google Cloud, Netflix, Microsoft, Box, Phia, a16z, ElevenLabs, Wayve, Hugging Face, Elad Gil, and Vinod Khosla to the stages — part of 250+ industry leaders driving 200+ sessions built to fuel your growth and sharpen your edge. Plus, meet the hundreds of startups innovating across every sector.

Mit dem neuen Modell kann man in der Gemini-App auch App-Prototypen mithilfe von Prompts erstellen.

Das Gemini 3 Pro ist jetzt für alle in den USA für die Suche verfügbar, und mehr Menschen in den USA können auch auf das Nano Banana Pro Bildmodell in der Suche zugreifen.

Verfügbarkeit für Unternehmen und Entwickler

Google wies darauf hin, dass Unternehmen wie JetBrains, Figma, Cursor, Harvey und Latitude bereits das Gemini 3 Flash-Modell nutzen, das über Vertex AI und Gemini Enterprise verfügbar ist.

Für Entwickler stellt das Unternehmen das Modell in einer Vorschauversion über die API und in Antigravity, dem neuen Coding-Tool von Google, das letzten Monat veröffentlicht wurde, zur Verfügung.

Das Unternehmen erklärte, dass das Gemini 3 Pro im SWE-bench-verifizierten Coding-Benchmark 78 % erreicht und nur von GPT-5.2 übertroffen wird. Es fügte hinzu, dass das Modell ideal für Videoanalyse, Datenextraktion und visuelle Q&A ist und sich aufgrund seiner Geschwindigkeit für schnelle und wiederholbare Workflows eignet.

Image Credits: Google

Image Credits: Google Die Modellpreise liegen bei $0,50 pro 1 Million Eingabetokens und $3,00 pro 1 Million Ausgabetokens. Das ist etwas teurer als $0,30 pro 1 Million Eingabetokens und $2,50 pro 1 Million Ausgabetokens von Gemini Flash 2.5. Google behauptet jedoch, dass das neue Modell das Gemini 2.5 Pro-Modell übertrifft und dabei dreimal schneller ist. Und für Denkaufgaben verwendet es im Durchschnitt 30 % weniger Tokens als 2.5 Pro. Das bedeutet, dass man insgesamt bei bestimmten Aufgaben Tokens sparen könnte.

Image Credits: Google

Image Credits: Google „Wir positionieren Flash wirklich eher als Ihr Arbeitspferd-Modell. Wenn Sie sich zum Beispiel sogar die Eingabe- und Ausgabepreise oben in dieser Tabelle ansehen, ist Flash aus Sicht der Eingabe- und Ausgabepreise einfach ein viel günstigeres Angebot. Und so ermöglicht es tatsächlich vielen Unternehmen, Aufgaben in großen Mengen zu erledigen“, sagte Tulsee Doshi, Senior Director & Head of Product für Gemini-Modelle, TechCrunch in einem Briefing.

Seit der Veröffentlichung von Gemini 3 hat Google über seine API mehr als 1 Billion Tokens pro Tag verarbeitet, während es sich einen heftigen Veröffentlichungs- und Performance-Wettstreit mit OpenAI liefert.

Anfang dieses Monats soll Sam Altman ein internes „Code Red“-Memo an das OpenAI-Team geschickt haben, nachdem der Traffic von ChatGPT zurückgegangen war, während Googles Marktanteil bei Verbrauchern stieg. Danach hat OpenAI GPT-5.2 und ein neues Bildgenerierungsmodell veröffentlicht. OpenAI prahlte außerdem mit seiner wachsenden Nutzung im Unternehmensbereich und erklärte, dass das Nachrichtenvolumen von ChatGPT seit November 2024 um das Achtfache gestiegen sei.

Während Google den Wettbewerb mit OpenAI nicht direkt ansprach, erklärte das Unternehmen, dass die Veröffentlichung neuer Modelle alle Unternehmen dazu herausfordert, aktiv zu sein.

„Was gerade in der Branche passiert, ist, dass all diese Modelle weiterhin großartig sind, sich gegenseitig herausfordern und die Grenzen verschieben. Und ich denke, es ist auch großartig, wie Unternehmen diese Modelle veröffentlichen“, sagte Doshi.

„Wir führen auch neue Benchmarks und neue Möglichkeiten zur Bewertung dieser Modelle ein. Und das motiviert uns ebenfalls.“