Microsoft continuera d'acheter des puces d'IA auprès de Nvidia et AMD, même après avoir lancé les siennes, selon Nadella

Microsoft dévoile sa première puce IA développée en interne

Microsoft a commencé à déployer pour la première fois ses propres puces IA propriétaires dans ses centres de données, avec l’intention d’élargir leur utilisation dans un avenir proche. L’entreprise a annoncé cette étape importante alors qu’elle continue d’investir dans le développement de son propre matériel pour les charges de travail en intelligence artificielle.

La nouvelle puce, baptisée Maia 200, a été conçue spécifiquement pour les tâches d’inférence IA—ce qui la rend particulièrement efficace pour exécuter des modèles IA complexes dans des applications réelles. Selon Microsoft, Maia 200 offre des vitesses de traitement qui dépassent celles des dernières puces IA d’Amazon (Trainium) et Google (TPU), la positionnant comme une référence en matière de performance.

Les principaux fournisseurs de cloud conçoivent de plus en plus leurs propres puces IA en raison des difficultés persistantes à se procurer les derniers matériels auprès de Nvidia, dont les produits restent rares et très demandés.

Malgré cette avancée technologique, le PDG de Microsoft, Satya Nadella, a souligné que l’entreprise continuera d’acheter des puces auprès d’autres fabricants. « Nous avons de solides collaborations avec Nvidia et AMD. Les deux entreprises repoussent les limites de l’innovation, tout comme nous », a déclaré Nadella. Il a également noté : « Rester en avance est un voyage continu, pas une réalisation unique. »

Nadella a par ailleurs précisé que même si Microsoft est capable de construire ses propres systèmes intégrés verticalement, elle n’a pas l’intention de s’appuyer uniquement sur ses propres solutions matérielles.

L’équipe Superintelligence en tête de l’utilisation de Maia 200

La puce Maia 200 sera utilisée par la division Superintelligence de Microsoft, un groupe dédié au développement des modèles IA de nouvelle génération de l’entreprise. Mustafa Suleyman, ancien cofondateur de Google DeepMind et désormais à la tête de cette équipe, a indiqué que ces efforts pourraient à terme réduire la dépendance de Microsoft à l’égard de fournisseurs externes de modèles IA tels qu’OpenAI et Anthropic.

Soutien à OpenAI et Azure

Microsoft prévoit également d’utiliser Maia 200 pour alimenter les modèles d’OpenAI sur sa plateforme cloud Azure. Cependant, l’entreprise reconnaît que l’accès au matériel IA le plus avancé demeure un obstacle majeur tant pour les clients externes que pour les équipes internes.

Dans une publication récente sur X, Suleyman a exprimé sa satisfaction quant à l’accès anticipé de son équipe à la nouvelle puce, déclarant : « C’est une étape importante. Notre groupe Superintelligence sera le premier à exploiter Maia 200 alors que nous repoussons les limites des modèles IA de pointe. »

Sommet des Fondateurs TechCrunch 2026

23 juin, Boston, MA – Plus de 1 100 fondateurs se réuniront lors du Sommet des Fondateurs TechCrunch 2026 pour une journée entière dédiée aux stratégies de croissance, à l’exécution et au passage à l’échelle des entreprises dans le monde réel. Les participants auront l’opportunité d’apprendre auprès de fondateurs et investisseurs de premier plan, de réseauter avec des pairs confrontés à des défis similaires et de repartir avec des idées concrètes à mettre en pratique.

- Économisez jusqu’à 300 $ sur votre billet

- Les équipes de quatre personnes ou plus bénéficient jusqu’à 30 % de réduction sur les pass groupés

Avertissement : le contenu de cet article reflète uniquement le point de vue de l'auteur et ne représente en aucun cas la plateforme. Cet article n'est pas destiné à servir de référence pour prendre des décisions d'investissement.

Vous pourriez également aimer

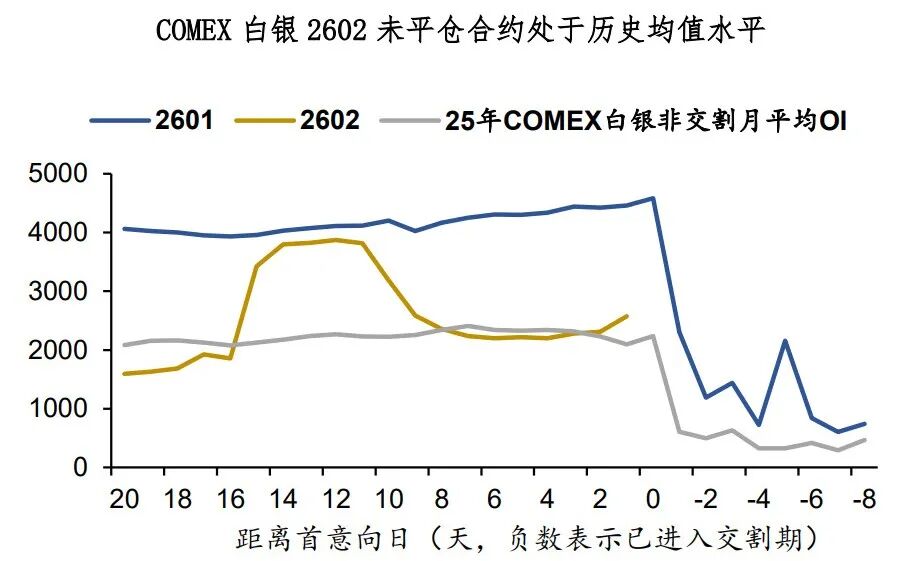

Argent : le marché haussier a besoin de reprendre son souffle

Indices des prix à la production, Australie, décembre 2025

Optimism approuve à l’issue d’un vote très disputé le programme de rachat de OP

L’iPhone vient de connaître son meilleur trimestre de tous les temps